이 논문은 제목에서 보여지는 것처럼 특정인의 얼굴을 활용해 원하는 이미지를 그려내는 personalization task를 풀고 있다. 기존 연구의 어떤 문제를 어떻게 해결했는지를 알아보겠다.

기존 연구의 문제점

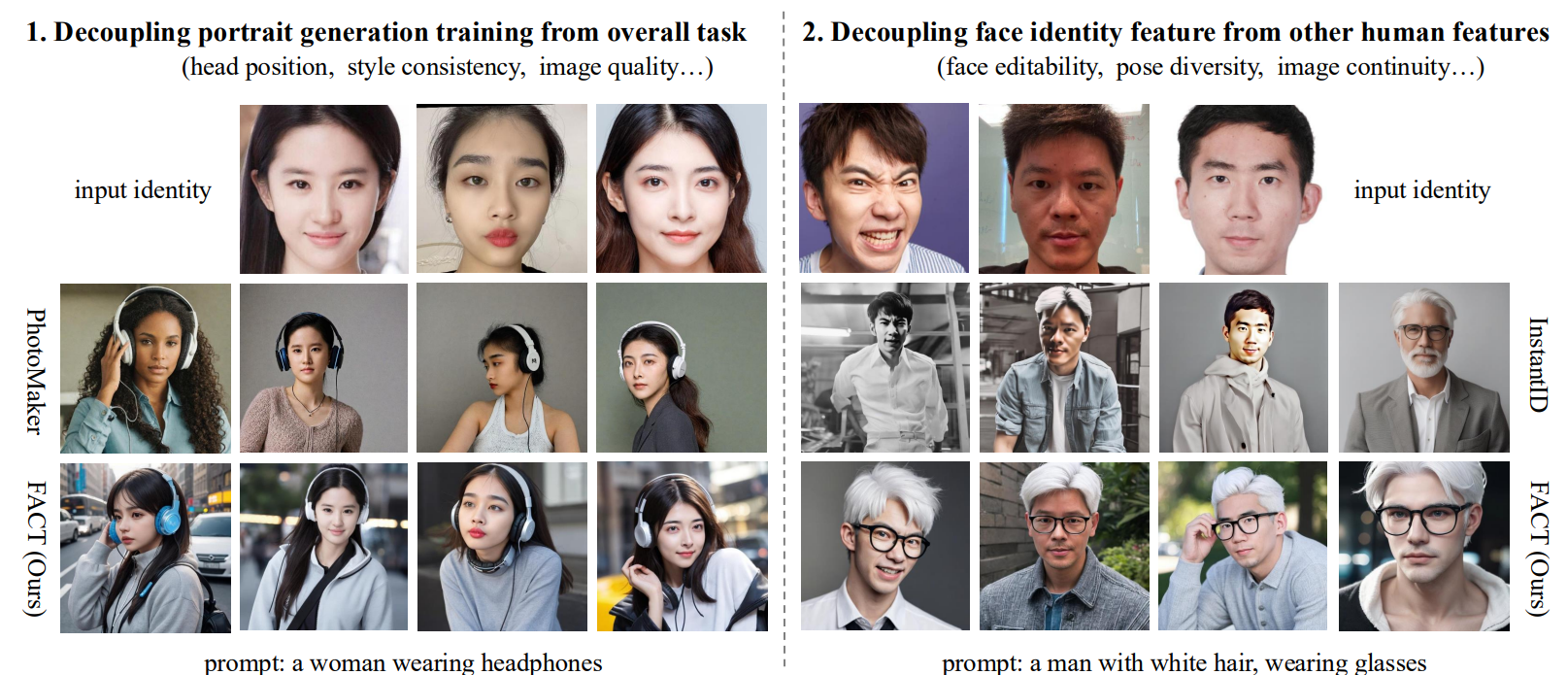

기존에도 ip-adapter 또는 photomaker, instantID 같이 얼굴 이미지를 활용해 원하는 이미지를 그려내는 연구는 많이 있었다. 하지만, 저자들은 이들 연구들이 입력 이미지를 결과 이미지에 어떻게 합성하는지에 대해서만 고민했기 때문에 원본 이미지의 머리방향, 스타일, 포즈 같은 다른 property들이 decouple 되지 않았다고 한다. 이에 저자들은 이를 decouple하는데 초점을 맞춘 FACT 아키텍처를 제안한다.

아이디어

크게 IMM (Identity Merging Module)과 FAIR (Face Adapting Increment Regularization) 두개의 구조로 이루어져 있다.

Identity를 인코딩 하는데 있어, 저자들은 두 가지를 고려해 ViT 기반의 TransFace 모델을 활용해 feature를 추출했다.

1) Attention 연산을 위해 Identity feature가 stable diffusion 의 feature space와 align될 것

2) Identity feature가 한 인물의 공통점을 충분히 표현하면서 다른 인물들 사이의 차이점을 충분히 나타낼 수 있을 것

Identity를 perserving 하면서 학습하는 아키텍처로 저자들은 attention map이 layer가 달라지면 다른 영역에 집중하는 등, 제대로 working하지 못하는것에 착안해, face 외부 영역에서 face adapter의 중요도를 점차 줄이는 FAIR 아키텍처를 제안했다.

결론 및 느낀점

이미지를 생성하는데 있어 논문에서 보여지는 결과물들의 차이는 크게 느껴지지 않는다. 다만, 템플릿 대로 레퍼런스 이미지를 생성하는 것은 확실히 차이가 느껴지는데, 다른 baseline 연구들과 달리 decoupling이 잘 되기 때문일 것 같다. Face encoder로 ViT기반의 pretrained TransFace를 사용했는데, 여기서의 효과도 ablation에서 함께 다루어줬다면 좋았을 것 같다.

모델 구조나 파이프라인이 그림과 매치되지 않는 부분이 있어 저자들의 논리구조와 전반적인 아키텍처를 이해하는데는 조금 불친절했다.